|

|

楼主 |

发表于 2025-7-15 13:31:54

|

显示全部楼层

本帖最后由 爱国者999 于 2025-7-15 13:44 编辑

苹果 ( Apple ) +三星 ( Samsung ) +华为 ( Huawei )+戴尔 ( Dell ) +索尼 ( Sony )

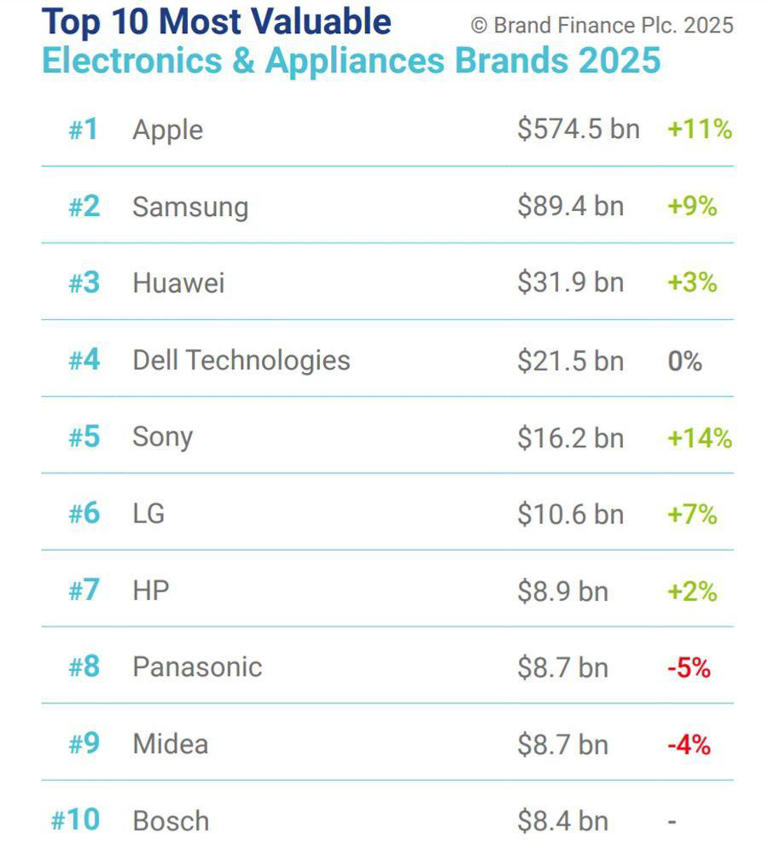

2025全球电子和家电品牌价值50强榜单TOP5

英国品牌评估机构“品牌金融” ( Brand Finance ) 发布 2025 “全球电子家电品牌价值 50 强”排行榜 ( Electronics & Appliances 50 2025 ) ,苹果、三星、华为蝉联前三位.

品牌价值被理解为品牌所有者通过在公开市场上许可该品牌所获得的净经济收益。

排名 品牌 总部所在地 品牌价值 / 年增长率

1、苹果 ( Apple ) 美国 5745.10 亿美元 /+11.2%

2、三星 ( Samsung ) 韩国 894.27 亿美元 /+8.8%

3、华为 ( Huawei ) 中国-深圳 319.21 亿美元 /+2.7%

4、戴尔 ( Dell Technologies ) 美国 214.51 亿美元 /+0.1%

5、索尼 ( Sony ) 日本 161.92 亿美元 /+13.5%

6、LG 韩国 105.49 亿美元 /+7.2%

7、惠普 ( HP ) 美国 89.40 亿美元 /+2.4%

8、松下 ( Panasonic ) 日本 87.33 亿美元 /-5.4%

9、美的 ( Midea ) 中国-佛山 87.23 亿美元 /-3.9%

10、博世 ( Bosch ) 德国 84.03 亿美元 /--

11、佳能 ( Canon ) 日本

12、小米 ( Xiaomi ) 中国-北京

13、PlayStation 日本

14、任天堂 ( Nintendo ) 日本

15、格力 ( Gree ) 中国-珠海

16、海尔 ( Haier ) 中国-山东

17、Xbox 美国

18、联想 ( Lenovo ) 中国-北京

19、海康威视 ( Hikvision ) 中国-浙江

20、Vivo 中国-深圳

21、摩托罗拉系统 ( Motorola Solutions ) 美国

22、三菱电机 ( Mitsubishi Electric ) 日本

23、OPPO 中国-深圳

24、富士胶片 ( Fujifilm ) 日本

25、中兴通讯 ( ZTE ) 中国-深圳

26、京瓷 ( Kyocera ) 日本

27、西部数据 ( Western Digital ) 美国

28、纬创 ( Wistron ) 中国-台湾

29、哈曼 ( Harman ) 韩国

30、歌尔 ( GoerTek ) 中国-山东

31、东芝 ( Toshiba ) 日本

32、惠而浦 ( Whirlpool ) 美国

33、华硕 ( ASUS ) 中国-台湾

34、尚科宁家 ( SharkNinja ) 美国

35、Seb 法国

36、苏泊尔 ( Supor ) 中国-浙江

37、小天鹅 ( Little Swan ) 中国-安徽

38、仁宝 ( Compal Electronics ) 中国-台湾

39、夏普 ( Sharp ) 日本

40、阿奇立克 ( Arcelik ) 土耳其

41、闪迪 ( Sandisk ) 美国

42、传音 ( Transsion ) 中国-深圳

43、英业达 ( Inventec Corporation ) 中国-台湾

44、美诺 ( Miele ) 德国

45、大疆 ( DJI ) 中国-深圳

46、罗技 ( Logitech ) 瑞士

47、科唯怡 ( Coway ) 韩国

48、安克 ( Anker ) 中国-深圳

49、微星科技 ( MSI ) 中国-台湾

50、中国TCL 中国-深圳

【中国科技核心资产-“十姐妹”】-Huawei、Tencent、BYD、SICARRIER、Alibaba、DJI、DouYin、Pxwsemi、大模型三剑客-[Pangu+Hunyuan+DeepSeek]、SwaySure

【美国科技核心资产-“十姐妹”】-Apple、Google、Amazon、Microsoft、Meta、Tesla、Nvidia、Intel、大模型三剑客-[OpenAI+xAI+Meta Llama]、Qualcomm

Global Technology Center:

【Shenzhen】-Guangdong-Hong Kong-Macao Greater Bay Area,【Silicon Valley】-San Francisco Greater Bay Area

深圳-粤港澳大湾区,硅谷-旧金山大湾区 |

|